구글이 대형언어모델(LLM) 수준의 번역 품질을 유지하면서 컴퓨팅 효율을 대폭 높인 오픈 소스 번역 모델 제품군을 선보였다. 작은 규모의 모델로도 정밀한 다국어 번역이 가능해져, 모바일 기기부터 클라우드 환경까지 폭넓게 활용할 수 있는 대안으로 주목된다.

구글은 15일(현지시간) 오픈 소스 번역 모델 제품군인 '트랜스레이트젬마(TranslateGemma)'를 공개했다. 전 세계 55개 언어 간 번역을 높은 효율과 품질로 지원하는 것이 특징이다.

'젬마 3(Gemma 3)'를 활용한 이번 모델은 4B, 12B, 27B 세가지 매개변수 규모로 제공된다.

구글은 최첨단 LLM의 지식을 작고 효율적인 오픈 모델로 압축(distillation)함으로써, 성능 저하 없이도 컴퓨팅 효율을 크게 끌어올렸다고 설명했다.

고자원·중간 자원·저자원 언어를 아우르는 55개 언어로 구성된 'WMT24++' 데이터셋에서 테스트 됐다.

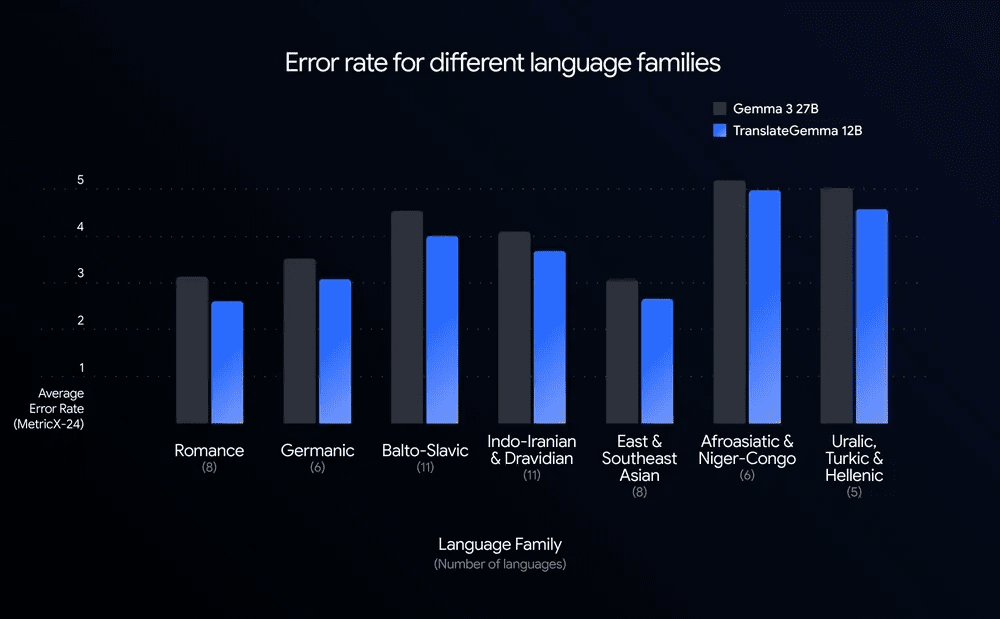

그 결과, 모든 언어에서 기존 젬마에 비해 오류율이 낮아졌다. 이는 번역 품질과 효율을 동시에 개선했음을 보여준다.

실제로, 12B 모델은 WMT24++에서 MetricX 기준으로 '젬마 3 27B' 기본 모델을 능가하는 성능을 기록했다. 매개변수 수가 절반 이하임에도 더 나은 번역 품질을 보여준 것이다.

개발자 입장에서는 의미 있는 변화다. 적은 연산 자원으로도 고품질 번역이 가능해지면서 처리량은 늘고 지연 시간은 줄일 수 있다.

특히, 4B 모델은 12B급 기존 모델과 유사한 성능을 보여 모바일이나 엣지 환경에서의 활용 가능성을 크게 넓혔다.

이런 성과는 두 단계로 구성된 특화된 미세조정 방식 때문이라고 설명했다.

먼저 지도 미세조정(SFT)을 통해 인간 번역 데이터와 '제미나이'가 생성한 고품질 합성 번역 데이터를 동시에 학습했다. 이후 강화 학습(RL) 단계에서는 MetricX-QE, AutoMQM 등 여러 보상 모델을 활용해 문맥에 더 자연스럽고 정확한 번역을 유도했다.

구글은 핵심 55개 언어 외에도 약 500개에 달하는 추가 언어 쌍에 대해 학습을 진행했다. 연구자들이 저자원 언어 개선이나 특정 언어 쌍에 맞춘 추가 학습을 할 수 있도록 기반 모델로 설계했다고 전했다.

또 트랜스레이트젬마는 젬마 3의 멀티모달 특성을 그대로 유지한다. 이미지 내 텍스트 번역 성능을 평가하는 '비스트라(Vistra)' 벤치마크에서도 별도의 멀티모달 학습 없이 성능 향상이 확인, 텍스트 번역 개선이 이미지 번역에도 긍정적인 영향을 미친 것으로 나타났다.

구글은 "이번 연구로 오픈 소스 번역 모델의 새로운 기준을 제시했다"라고 자평했다.

특히 4B 모델은 모바일·엣지 환경, 12B 모델은 일반 노트북 기반 로컬 개발, 27B 모델은 'H100' GPU나 TPU 한장으로 구동 가능한 클라우드 환경 등 활용 폭을 크게 넓혔다고 강조했다.

모델 군은 캐글, 허깅페이스, 젬마 쿡북, 버텍스 AI 등을 통해 공개됐다.

박찬 기자 cpark@aitimes.com

<저작권자 copyright ⓒ ai타임스 무단전재 및 재배포 금지>